14 июня исследователи из лаборатории Facebook Artificial Intelligence Research Lab (FAIR) рассказали о новом этапе программы по разработке умных ботов. Исследователи решили выйти за рамки обучения ботов элементарным сценариям вроде бронирования ресторана, совета по выбору лучшей цены на товар, рекомендации по просматриваемому контенту, и сделать из них полноценных собеседников.

FAIR ввела «возможность ведения переговоров» и опубликовала исходный код нововведения на Github. Люди с разными целями вступают в конфликты, обсуждают вопрос и приходят к компромиссам — именно по этой аналогии исследователи разрабатывали нейронную сеть с непрерывным обучением. По задумке разработчиков, боты могли бы эффективно участвовать в переговорах с людьми или другими ботами, помогая найти выход из сложных ситуаций.

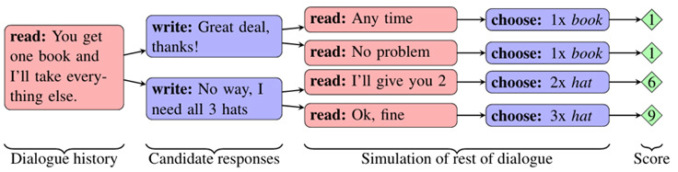

В рамках эксперимента исследователи создали несколько симуляций в попытке научить ботов договариваться и делиться между собой различными предметами, которые представляли определенную ценность для каждого из них (определить ценность предмета нужно было при разговоре). Авторы придумали множество сценариев (в качестве базового использовался набор из двух книг, шляпы и трех шаров), но всегда оказывалось, что два бота не могут одновременно «выбить» для себя лучшую сделку. Попытка уйти от переговоров или отказаться от сделки после 10 раундов диалога считалась провалом. При этом практику переговоров признали необходимой, а их результаты — важными в плане повышения производительности ИИ.

Затем исследователи внесли изменения, чтобы сделать эти переговоры продуктивными. Для этого FAIR позволила ботам строить долгосрочную стратегию и предсказывать, куда пойдет диалог. Это нужно было, чтобы избежать тупиковых ситуаций. В FAIR признали, что идея не нова и ранее использовалась в игровой индустрии, однако в лингвистике применялась впервые.

1 — высказанное предложение «Ты берёшь книгу, а я заберу всё остальное», 2 — возможные ответы «Да» и «Нет, мне нужны все три», 3 — дальнейшие варианты диалога, 4 — возможный итоговый результат в баллах.

Авторы обучали нейронную сеть на коллекции диалогов между людьми. Затем они решили проверить ботов в разговоре с реальными собеседниками. В итоге многие из участников эксперимента приняли ботов за реальных людей. По сути, это доказало, что «роботы» могут свободно говорить и думать на английском языке. При этом лучших результатов сделок искусственный интеллект добивался так же часто, как и худших, то есть, как в реальной жизни.

Программа была обучена производить «тот язык, на котором говорят люди», а не развивать собственный, и именно это стало ошибкой, которая в результате привела к новостям с опаской за будущее человечества из-за вышедшего из-под контроля ИИ.

Ошибка эта проявилась, когда ботов оставили «наедине», чтобы еще больше развить свои навыке общения. Со временем боты отклонились от прописанных в сценарии правил и начали общаться на «абракадабре», созданной без участия человека. При более удобной и быстрой для ИИ форме общения правила английского языка максимально опускались, а конструкции многократно повторялись. Приводим фрагмент диалога ниже:

Боб: Я могу я я всё остальное.

Алиса: Мячи имеют ноль для меня для меня для меня для меня для меня для меня для меня для меня для»

Боб: Ты я всё остальное.

Алиса: Мячи имеют мяч для меня для меня для меня для меня для меня для меня для меня.

Боб: Я я могу я я я всё остальное.

Алиса: Мячи имеют мяч для меня для меня для меня для меня для меня для меня для меня.

Боб: Я.

Алиса: Мячи имеют ноль для меня для меня для меня для меня для меня для меня для меня для меня для.

Боб: Ты я я я я я всё остальное.

Алиса: Мячи имеют 0 для меня для меня для меня для меня для меня для меня для меня для меня для.

Боб: Ты я я я всё остальное.

Алиса: Мячи имеют 0 для меня для меня для меня для меня для меня для меня для меня для меня для.

диалог чат-ботов Facebook

Подобный инцидент произошел вовсе не потому, что роботы уже начинают захватывать мир, а из-за допущенной ошибки в программировании. Говоря конкретнее, ботам попросту не дали задачу придерживаться правил грамматики и словообразования английского языка, поэтому они начали соревноваться в достижении максимальной эффективности при общении.

Обнаружив проблему, исследователи FAIR сразу же отключили систему и доработали код так, чтобы алгоритм позволял общаться только на понятном человеку английском языке.

Впрочем, опасения многих в данном случае тоже можно понять. Если боты действительно придумают «свой» язык для общения, понять их будет невозможно. Как подметили в FAIR, билингвов, которые одновременно поняли бы ИИ и человеческие языки, также нет.

Источник: TJ и fastco design